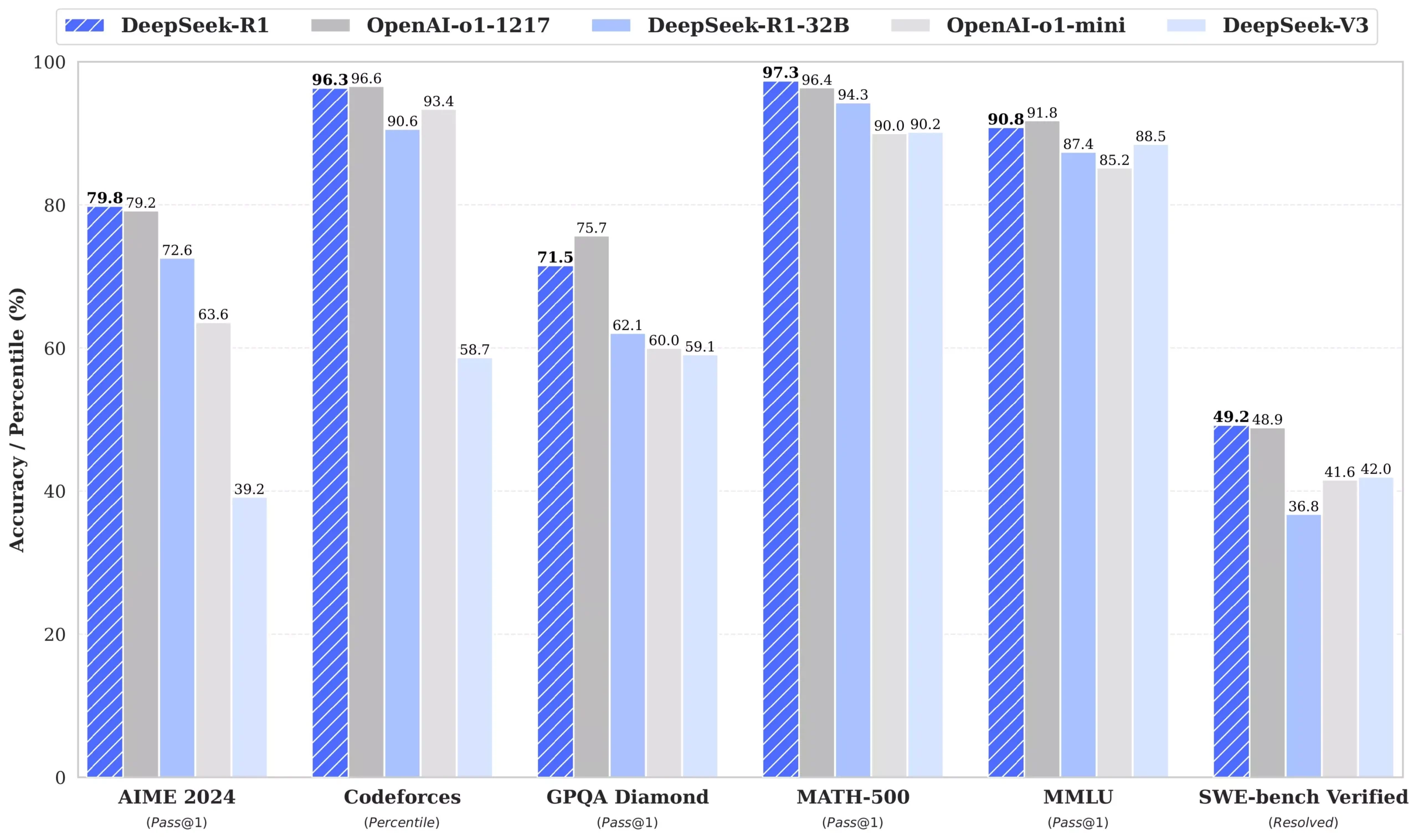

最近,DeepSeek的初创公司发布了全新一代大模型,“DeepSeek-V3”,DeepSeek R1 更是直接免费开源。由于这款大模型太过好用,引发了网友的连连称赞。各项性能指标更是和OpenAI-o1 模型不相上下,甚至做到了小部分的超越,关键是开源的,我们可以本地部署使用

一、资源摘要:

本地部署,我们可以通过Ollama来进行安装

1.下载安装Ollama 官方版:

https://ollama.com/

2.通过Web UI 控制端使用模型 :

https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

3.安装命令

(1)显存4G以下 1.5B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:1.5b

(2)显存8G 7B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:7b

(3)显存12G 8B Llama DeepSeek R1

安装命令 ollama run deepseek-r1:8b

(4)显存12G-24G 14B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:14b

(5)显存24G以上 32B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:32b

(6)显存48G及以上 70B Llama DeepSeek R1

安装命令 ollama run deepseek-r1:70b

二、安装教程

1.实现魔法上网,安装好chrom谷歌浏览器,并能打开google.cn (第1步网上自行操作)

2.下载ollama客户端并安装(共754.359M):网址 https://ollama.com/

3.ollama安装完成点击右下角弹出的页面“click here to get started”

4.进入ollama客户端

5.复制粘贴安装命令,回车(以我为例:我的4060显卡,显存8G 对应安装命令为:ollama run deepseek-r1:7b)

6.回车后自动安装

7.如图显示安装完成。(在这个界面就可以实现模型问答,但不方便,我们进一步安装网页端插件,通过网页访问)

8打开.Web UI 控制端网页 :

https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

点击添加至chrom浏览器

9.在扩展处找到page assist本地AI

10.进入界面后,选择r1模型

11.点击右上角设置一下

12.返回网页端界面

13.即可正常使用(注意打开魔法上网)

三、获取帮助

青蛙能跳,却难跳出井底。因为向上的跳跃不可积累。要走出AI井底,就要学习蜗牛精神,积累硅步稳步向前,一定能爬出井口。

(1)蜗牛AI落地1.0群

(群二维码2025年2月9日失效)

(2)添加博主

-e1738475006400-287x300.jpg)